La desviación en estadística es un concepto fundamental que nos permite entender la variabilidad y dispersión de un conjunto de datos. Se refiere a la medida en que los valores de una serie se desvían de su promedio o media aritmética. Esta información es crucial para la interpretación de resultados en diversos campos, desde la investigación científica hasta el análisis financiero.

En este artículo, exploraremos en profundidad qué es la desviación, cómo se calcula y qué implicaciones tiene en el análisis estadístico. Te invitamos a seguir leyendo para descubrir por qué este concepto es tan esencial en la estadística moderna y cómo puede afectar tus conclusiones.

Contenido

- 1 Entendiendo la Desviación: Definición y Relevancia en Estadística

- 2 Desviación típica: interpretación y uso combinado con la media

- 3 Qué es la Desviación Estándar – Típica

- 4 ¿Cuál es el significado de desviación en estadística?

- 5 ¿Qué significa desviación en estadísticas?

- 6 ¿Qué se entiende por desviación en una medición?

- 7 ¿Qué son la desviación y la varianza?

- 8 Preguntas Frecuentes

Entendiendo la Desviación: Definición y Relevancia en Estadística

La desviación es un concepto fundamental en el ámbito de la estadística, ya que permite medir la variabilidad y dispersión de un conjunto de datos. Se refiere a la diferencia entre un valor observado y un valor promedio o esperado, lo que proporciona información crucial sobre el comportamiento de los datos en estudio.

Definición: La desviación se puede definir como la cantidad que se aleja un dato de la media aritmética de un conjunto de datos. La fórmula general para calcular la desviación de un dato ( x_i ) con respecto a la media ( mu ) se expresa como:

[ d_i = x_i – mu ]

donde ( d_i ) representa la desviación del dato ( x_i ).

En la práctica, se utilizan diferentes tipos de desviación, siendo los más comunes los siguientes:

- Desviación estándar: Mide la dispersión de un conjunto de datos a partir de su media. Se calcula como la raíz cuadrada de la varianza.

- Desviación absoluta media: Representa el promedio de las desviaciones absolutas de cada dato respecto a la media.

- Desviación intercuartílica: Indica la variabilidad de un conjunto de datos en términos de los cuartiles 1 y 3, proporcionando una medida de dispersión que es menos sensible a valores atípicos.

La relevancia de la desviación en estadística es indiscutible, ya que ofrece varias ventajas importantes:

- Evaluación de la variabilidad: Permite a los analistas y científicos comprender cuán dispersos están los datos alrededor de la media, lo que es crucial para interpretar los resultados de manera precisa.

- Comparaciones efectivas: Facilita la comparación entre diferentes conjuntos de datos, permitiendo identificar cuál es más variable o estable.

- Identificación de valores atípicos: Ayuda a localizar observaciones que se desvían significativamente del conjunto de datos general, lo que puede ser vital en investigaciones científicas o estudios de mercado.

- Fundamento para análisis avanzados: Sirve como base para otros análisis estadísticos, como la inferencia, donde se generan estimaciones y se establecen intervalos de confianza.

En resumen, entender la desviación y su cálculo es esencial para cualquier investigador o profesional que trabaje con datos. Proporciona una visión clara de la distribución, variabilidad y fiabilidad de los resultados obtenidos, siendo una herramienta indispensable en la toma de decisiones informadas.

Desviación típica: interpretación y uso combinado con la media

Qué es la Desviación Estándar – Típica

¿Cuál es el significado de desviación en estadística?

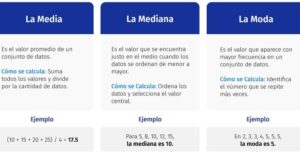

En estadística, el término desviación se refiere a la medida de cómo se dispersan o separan los valores de un conjunto de datos respecto a una medida central, como la media. Se utiliza para entender la variabilidad y la distribución de los datos.

La desviación puede ser calculada de diferentes maneras, siendo las más comunes:

1. Desviación Media: Es el promedio de las diferencias absolutas entre cada dato y la media del conjunto. Se expresa como:

[

text{Desviación Media} = frac{sum |x_i – bar{x}|}{n}

]

donde ( x_i ) son los valores del conjunto, ( bar{x} ) es la media, y ( n ) es el número total de observaciones.

2. Desviación Estándar: Mide cuánto se desvían los datos de la media en términos de unidades originales. Se calcula como la raíz cuadrada de la varianza:

[

text{Desviación Estándar} = sqrt{frac{sum (x_i – bar{x})^2}{n}}

]

Esto proporciona una idea de la concentración o dispersión de los datos alrededor de la media.

3. Desviación Típica: Es sinónimo de desviación estándar y se utiliza para describir la misma idea de dispersión.

En resumen, la desviación en estadística es fundamental para analizar la variabilidad y distribución de datos, proporcionando insights clave sobre la naturaleza del conjunto analizado.

¿Qué significa desviación en estadísticas?

En estadísticas, el término desviación se refiere a la medida en que un conjunto de datos se aparta de su valor promedio o media. La desviación puede ser utilizada para entender la variabilidad o dispersion de los datos.

Existen dos tipos principales de desviación:

1. Desviación absoluta: Es la diferencia entre cada valor del conjunto de datos y la media. Se calcula como:

[

|x_i – bar{x}|

]

donde ( x_i ) es cada valor individual y ( bar{x} ) es la media del conjunto.

2. Desviación estándar: Esta es una medida más comúnmente utilizada que indica cuánto se dispersan los valores respecto a la media. Se calcula tomando la raíz cuadrada de la varianza, que es el promedio de las desviaciones al cuadrado. La fórmula es:

[

s = sqrt{frac{1}{n-1} sum_{i=1}^{n} (x_i – bar{x})^2}

]

donde ( s ) es la desviación estándar, ( n ) es el número de observaciones y ( (x_i – bar{x})^2 ) son las desviaciones al cuadrado.

En resumen, la desviación en estadísticas es crucial para comprender cómo varían los datos dentro de un conjunto, permitiendo hacer análisis más profundos sobre su comportamiento y características.

¿Qué se entiende por desviación en una medición?

En el contexto de la medición, la desviación se refiere a la diferencia entre un valor medido y un valor de referencia o esperado. Esta puede ser tanto positiva como negativa, dependiendo de si el valor medido está por encima o por debajo del valor de referencia.

La desviación es un concepto fundamental en diversas disciplinas, como la estadística, la metrología y la ingeniería, ya que permite evaluar la precisión y exactitud de las mediciones. Cuando se habla de desviación, es común referirse a dos tipos principales:

1. Desviación absoluta: Es el valor absoluto de la diferencia entre el valor medido y el valor verdadero. Se calcula de la siguiente manera:

[

text{Desviación Absoluta} = | text{Valor Medido} – text{Valor Verdadero} |

]

2. Desviación relativa: Es la desviación absoluta expresada como un porcentaje del valor verdadero. Se utiliza para comparar la precisión de diferentes mediciones. Se calcula así:

[

text{Desviación Relativa} = left( frac{text{Desviación Absoluta}}{text{Valor Verdadero}} right) times 100

]

En resumen, la desviación en una medición es crucial para entender cuán cerca está un valor medido de un valor esperado y es fundamental para garantizar la calidad y fiabilidad en diversos ámbitos de estudio y aplicación.

¿Qué son la desviación y la varianza?

La desviación y la varianza son dos conceptos fundamentales en estadística que se utilizan para medir la dispersión de un conjunto de datos.

La desviación se refiere a la diferencia entre un valor individual y la media (promedio) de un conjunto de datos. Se puede expresar matemáticamente de la siguiente manera:

Desviación = Valor individual – Media

La desviación estándar, que es la raíz cuadrada de la varianza, proporciona una medida de cuánto se dispersan los valores respecto a la media. Una desviación estándar alta indica que los datos están más dispersos, mientras que una desviación estándar baja sugiere que los datos están más cerca de la media.

Por otro lado, la varianza es una medida que cuantifica esta dispersión de manera más global. Se calcula como la media de las desviaciones al cuadrado y se expresa de la siguiente manera:

Varianza = (Σ (Valor individual – Media)²) / n

donde Σ representa la suma y n es el número total de observaciones. La varianza ayuda a entender la extensión de la variabilidad en un conjunto de datos:

- Una varianza alta indica una gran dispersión entre los datos.

- Una varianza baja indica que los datos tienden a estar más agrupados alrededor de la media.

En resumen, tanto la desviación como la varianza son cruciales para el análisis estadístico, ya que proporcionan información sobre la distribución y variabilidad de los datos en estudio.

Preguntas Frecuentes

¿Qué es la desviación estándar y cómo se calcula?

La desviación estándar es una medida que cuantifica la variabilidad o dispersión de un conjunto de datos respecto a su media. Se calcula mediante los siguientes pasos:

1. Se halla la media del conjunto de datos.

2. Se calculan las diferencias entre cada dato y la media, elevando al cuadrado estas diferencias.

3. Se obtiene la media de las diferencias al cuadrado.

4. Finalmente, se saca la raíz cuadrada de ese valor.

Este proceso da como resultado la desviación estándar, que ayuda a entender cuán dispersos están los datos en relación con la media.

¿Cuál es la diferencia entre desviación estándar y varianza?

La varianza es una medida que cuantifica la dispersión de un conjunto de datos respecto a su media, calculándose como el promedio de las diferencias al cuadrado. Por otro lado, la desviación estándar es la raíz cuadrada de la varianza, lo que permite expresar la dispersión en las mismas unidades que los datos originales. En resumen, la varianza se mide en unidades al cuadrado, mientras que la desviación estándar se mide en unidades simples.

¿Por qué es importante la desviación en el análisis estadístico?

La desviación es crucial en el análisis estadístico porque mide la variabilidad de un conjunto de datos respecto a su media. Permite entender cómo se distribuyen los valores y si hay anomalías o tendencias en los datos. Una gran desviación indica una mayor dispersión, lo que puede influir en la precisión de las inferencias estadísticas y decisiones basadas en la información analizada.

¿Cómo se interpreta la desviación en un conjunto de datos?

La desviación en un conjunto de datos se refiere a la diferencia entre los valores individuales y el valor promedio del conjunto. Esta medida permite evaluar la variabilidad o dispersión de los datos; una desviación alta indica que los valores están más alejados del promedio, mientras que una desviación baja sugiere que están más concentrados alrededor de este.

En conclusión, la desviación en estadística es fundamental para comprender la variabilidad de los datos y su distribución. Este concepto permite un análisis más profundo y preciso de conjuntos numéricos. Te invitamos a compartir este contenido y seguir explorando más sobre conceptos estadísticos que enriquecen tu formación.