La estimación de errores en cálculo integral es un aspecto crucial en el análisis matemático que permite comprender la precisión y fiabilidad de los resultados obtenidos mediante métodos numéricos. A medida que nos adentramos en el mundo de las integrales, surge la necesidad de medir qué tan próxima está nuestra solución aproximada del valor real, lo que representa un desafío constante para estudiantes e investigadores.

En este artículo, exploraremos a fondo el concepto de estimación de errores, abordando sus fundamentos teóricos y su aplicación práctica en diferentes contextos. Si buscas mejorar tu comprensión sobre este tema esencial y perfeccionar tus habilidades en cálculo integral, te invitamos a seguir leyendo y descubrir los métodos más efectivos para estimar el error en tus cálculos.

Contenido

- 1 ### Entendiendo la Estimación de Errores en el Cálculo Integral: Conceptos Clave y Su Importancia

- 2 Error de Aproximación

- 3 Curso de Integrales. Capítulo 1: ¿Qué es y para qué sirve la integral? Una propuesta didáctica.

- 4 ¿Qué significa la estimación del error?

- 5 ¿Qué se entiende por estimación de errores?

- 6 ¿Qué significa un cálculo de errores?

- 7 ¿Cómo se determina el error de medición?

- 8 Preguntas Frecuentes

- 8.1 ¿Cuál es el concepto de estimación de errores en el cálculo integral y cómo se aplica en la práctica?

- 8.2 ¿Qué métodos existen para calcular la estimación de errores en los integrales definidos e indefinidos?

- 8.3 ¿Cómo se relaciona la estimación de errores en cálculo integral con la convergencia de series numéricas?

- 8.4 ¿Qué papel juegan las reglas de Simpson y Trapezoidal en la estimación de errores en integraciones numéricas?

### Entendiendo la Estimación de Errores en el Cálculo Integral: Conceptos Clave y Su Importancia

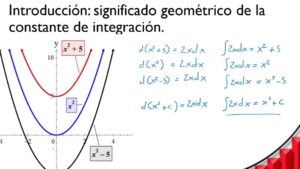

La estimación de errores en el cálculo integral es un aspecto crucial para garantizar la precisión y confiabilidad de los resultados obtenidos a través de métodos numéricos. Este concepto se refiere a las diferencias entre el valor real de una integral y el valor aproximado que se obtiene por medio de técnicas de cálculo.

Existen varios tipos de errores que se pueden analizar:

- Error absoluto: Es la diferencia entre el valor exacto de la integral y el valor aproximado.

- Error relativo: Se refiere a la relación entre el error absoluto y el valor exacto, expresado generalmente como un porcentaje.

- Error truncamiento: Se produce cuando se detiene el proceso de integración antes de que se alcancen suficientes términos en una serie o un método iterativo.

- Error de redondeo: Ocurre debido a la limitación en la representación de números en la computadora, lo que afecta los cálculos con cifras decimales.

Para entender la estimación de errores, es vital tener en cuenta los métodos más comunes de cálculo integral, como:

- Regla del Trapecio: Se utiliza para aproximar el área bajo la curva dividiendo el intervalo en segmentos y sumando áreas de trapecios.

- Regla de Simpson: Mejora la aproximación mediante el uso de polinomios de segundo grado para encontrar áreas.

- Métodos de Monte Carlo: Utilizan la aleatoriedad para estimar el valor de integrales, particularmente útiles en dimensiones altas.

Cada uno de estos métodos tiene su propia fuente de error, y el análisis del error es esencial para determinar la viabilidad de los resultados. Por ejemplo, en la regla del trapecio, el error puede ser estimado mediante la derivada de la función evaluada en el intervalo, mientras que la regla de Simpson presenta un menor error en comparación con la anterior debido a su consideración de la curvatura de la función.

Un aspecto importante es que el error total se puede estimar combinando los errores truncamiento y redondeo. Esto permite a los matemáticos y científicos ajustar sus métodos de integración según el nivel de precisión deseado.

Además, en aplicaciones prácticas como la ingeniería, la física o la economía, entender cómo se comporta el error en la estimación de integrales es fundamental. Esto es especialmente cierto en situaciones donde las decisiones deben tomarse con base en cálculos que dependen de integrales definidas, donde un pequeño margen de error puede llevar a resultados significativamente diferentes.

En resumen, la estimación de errores en el cálculo integral no solo proporciona una medida de la calidad de los resultados obtenidos, sino que también es una herramienta vital para evaluar y mejorar la eficacia de los métodos numéricos utilizados en diversas disciplinas científicas y de ingeniería.

Error de Aproximación

Curso de Integrales. Capítulo 1: ¿Qué es y para qué sirve la integral? Una propuesta didáctica.

¿Qué significa la estimación del error?

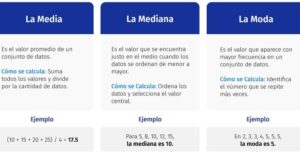

La estimación del error se refiere al proceso de determinar el grado de imprecisión o variabilidad en un resultado obtenido a partir de un modelo, medición o cálculo. En el contexto de conceptos y definiciones, es crucial para entender la fiabilidad y exactitud de los datos.

Cuando se realiza una medición, siempre existe la posibilidad de que el resultado no refleje con precisión el valor verdadero debido a diversas fuentes de error, como errores sistemáticos o aleatorios. Por lo tanto, la estimación del error permite a los investigadores y profesionales cuantificar cuán lejos puede estar su resultado del valor real.

Esta estimación puede expresarse de diferentes maneras, como un intervalo de confianza, un porcentaje de error o utilizando estadísticos que describen la variabilidad de los datos. En resumen, la estimación del error es fundamental para interpretar resultados de manera adecuada y tomar decisiones informadas basadas en ellos.

¿Qué se entiende por estimación de errores?

La estimación de errores se refiere al proceso mediante el cual se evalúa y cuantifica la incertidumbre o inexactitud en los resultados de una medición o cálculo. Esta práctica es fundamental en diversas disciplinas, como la estadística, la investigación científica y la ingeniería, donde es necesario comprender cuán precisos son los datos obtenidos.

En términos generales, la estimación de errores permite identificar las posibles fuentes de error, que pueden ser sistemáticas (errores constantes que afectan la precisión) o aleatorias (variaciones impredecibles). La estimación puede incluir diferentes tipos de errores, como el error absoluto (la diferencia entre el valor medido y el valor verdadero) y el error relativo (el error absoluto expresado como una fracción del valor verdadero).

El objetivo principal de la estimación de errores es proporcionar un marco cuantitativo para evaluar la fiabilidad de los datos y facilitar la toma de decisiones basadas en esos resultados. Al conocer el nivel de incertidumbre, los investigadores y profesionales pueden hacer ajustes, mejorar sus métodos de medición y, en última instancia, aumentar la calidad y exactitud de su trabajo.

¿Qué significa un cálculo de errores?

Un cálculo de errores se refiere a la evaluación y cuantificación de las discrepancias que pueden surgir entre un valor medido o calculado y el valor verdadero o esperado. Este concepto es fundamental en diversas disciplinas, como la estadística, la ingeniería y las ciencias experimentales, ya que permite entender la precisión y exactitud de los resultados obtenidos.

Existen diferentes tipos de errores que pueden ser considerados en un cálculo de errores:

1. Error sistemático: Este tipo de error se produce de manera constante y predecible, afectando todas las mediciones en la misma dirección. Puede ser causado por un mal funcionamiento del instrumento de medición o por condiciones ambientales.

2. Error aleatorio: Estos errores son impredecibles y varían de una medición a otra. Pueden deberse a fluctuaciones en el ambiente o limitaciones inherentes a los instrumentos de medición.

3. Error absoluto: Se define como la diferencia entre el valor medido y el valor verdadero. Este error proporciona una medida directa de la precisión de una medición.

4. Error relativo: Este se expresa como una fracción o porcentaje del valor verdadero y permite comparar la magnitud del error en relación con el tamaño de la medición.

El cálculo de errores no solo implica identificar y cuantificar estos errores, sino también implementarlos en la evaluación de la confiabilidad de los datos y en la toma de decisiones basadas en esos datos. Por lo tanto, es esencial para asegurar la calidad y validez de los resultados en cualquier investigación o actividad técnica.

¿Cómo se determina el error de medición?

El error de medición se refiere a la discrepancia entre el valor real de una magnitud y el valor que se obtiene al realizar una medición. Este error puede ser causado por diversos factores, y su determinación es crucial en cualquier ámbito científico o técnico. A continuación, se explican los pasos para determinar el error de medición:

1. Identificación del valor verdadero: Primero, es necesario conocer el valor real o expectante de la magnitud que se está midiendo. Esto puede ser un valor aceptado como referencia o un estándar.

2. Realización de la medición: Se lleva a cabo la medición utilizando un instrumento adecuado, obteniendo así un valor medido.

3. Cálculo del error: El error de medición se puede calcular utilizando la fórmula:

[

text{Error} = text{Valor medido} – text{Valor verdadero}

]

Esto permite establecer si la medición tiene un desvío positivo (cuando el valor medido es mayor) o un desvío negativo (cuando es menor).

4. Análisis de las fuentes de error: Es esencial identificar y categorizar las fuentes de error, que pueden ser sistemáticas (que afectan de manera constante a las mediciones) o aleatorias (que generan variaciones impredecibles).

5. Estadística aplicable: En ocasiones, se realizan múltiples mediciones para obtener un promedio y evaluar el error tipo mediante técnicas estadísticas, como el cálculo de la desviación estándar.

6. Expresión del resultado: Finalmente, se debe expresar el resultado de la medición junto con el error asociado, generalmente indicado como “±” para mostrar la incertidumbre de la medición.

Determinar el error de medición es fundamental para asegurar la precisión y exactitud de los resultados obtenidos, lo que a su vez contribuye a la fiabilidad de los experimentos y análisis en cualquier disciplina científica.

Preguntas Frecuentes

¿Cuál es el concepto de estimación de errores en el cálculo integral y cómo se aplica en la práctica?

El concepto de estimación de errores en el cálculo integral se refiere a la evaluación de la discrepancia entre el valor exacto de una integral y el valor aproximado obtenido mediante métodos numéricos, como la regla del trapecio o la regla de Simpson. En la práctica, se aplica para determinar la precisión de los resultados y para ajustar el tamaño de los intervalos, asegurando que el error se mantenga dentro de un umbral aceptable. Esto es fundamental en campos como la ingeniería y las ciencias aplicadas, donde se requieren cálculos precisos para la toma de decisiones.

¿Qué métodos existen para calcular la estimación de errores en los integrales definidos e indefinidos?

Existen varios métodos para calcular la estimación de errores en integrales definidas e indefinidas. Algunos de los más conocidos son:

1. Método del Trapecio: Estima el error utilizando la segunda derivada de la función.

2. Regla de Simpson: Proporciona una estimación del error basándose en la cuarta derivada de la función.

3. Errores de interpolación: Se utilizan para aproximar el error en las integrales al comparar con funciones polinómicas.

El ajuste de estos métodos depende de la suavidad de la función y el tamaño del intervalo de integración.

¿Cómo se relaciona la estimación de errores en cálculo integral con la convergencia de series numéricas?

La estimación de errores en cálculo integral se refiere a cómo medir la discrepancia entre el valor exacto de una integral y su aproximación numérica. Esta estimación está relacionada con la convergencia de series numéricas porque ambas estudian la aproximación de valores y la precisión de los resultados obtenidos. En particular, una integral se puede expresar como una serie de términos, y el análisis del error implica evaluar si esta serie converge a un valor finito, lo que garantiza que la aproximación es válida y precisa.

¿Qué papel juegan las reglas de Simpson y Trapezoidal en la estimación de errores en integraciones numéricas?

Las reglas de Simpson y Trapezoidal son métodos de integración numérica que permiten aproximar el valor de integrales definidas. Su papel en la estimación de errores radica en que cada uno tiene un orden de convergencia diferente, lo que influye en la precisión de la aproximación. La regla del trapezoide tiene un error de orden O(h²), mientras que la regla de Simpson tiene un error de orden O(h⁴). Así, al analizar el tamaño del paso (h) utilizado, se puede estimar el error cometido en la integración, permitiendo elegir el método más adecuado en función de la precisión requerida.

En conclusión, la estimación de errores en cálculo integral es fundamental para asegurar la precisión en los resultados obtenidos. Comprender este concepto permite optimizar el proceso de integración y mejorar la calidad del análisis. Te invitamos a compartir este contenido y a seguir explorando más sobre temas relacionados.